RL救不了泛化性!揭示LLM数学Reasoning的深层瓶颈

仅用于站内搜索,没有排版格式,具体信息请跳转上方微信公众号内链接

大型语言模型(LLM)在数学竞赛级任务(如IMO)上表现亮眼,但依赖机械化的推理模式。当问题需要跳出常规思维(如创新策略或技能组合)时,模型表现急剧下降。现有数学评测集(如GSM8K)存在两大缺陷:

混杂性强:不同题型混合,难以定位失败原因;

挑战不足:复杂度远低于奥赛水平,或缺乏系统性泛化测试。

为此,UCBerkeley团队提出OMEGA基准,首次从探索性、组合性、变革性三个维度量化LLM的数学泛化能力,揭示其创造性推理的深层瓶颈。

链接:https ://arxiv. org/pdf/2506. 18880

受认知科学中创造力理论启发,OMEGA定义三类泛化:

训练:计算八边形内矩形数量测试:计算十二边形内矩形数量

训练:分别学习多项式GCD和求根测试:求GCD后解方程

训练:暴力枚举路径数量测试:用\“总路径数-无效路径\“的逆向思维

复杂度控制:通过参数θ调节难度,如:

矩阵秩问题:矩阵维度δ(θ)=rows(3×3→9×9)

多项式求根:最高次数δ(θ)=degree(3次→7次)

答案验证:符号计算(SymPy)、数值模拟、计算机视觉(OpenCV)三重校验。

探索性:训练δ≤2的简单实例,测试δ>2的复杂实例;

组合性:训练单独技能A/B,测试A⊕B的协同应用;

变革性:训练传统解法,测试需创新策略的变体。

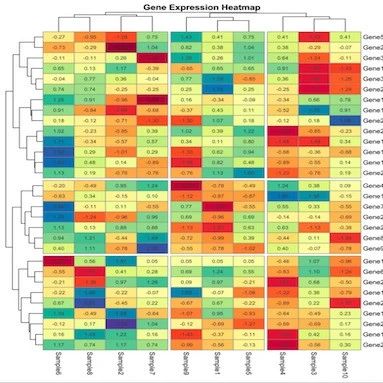

当问题复杂度(如矩阵维度、多项式次数)提升时,所有顶尖模型(DeepSeek-R1,Claude-3. 7等)准确率归零:

归因于两种推理失效模式:

自我推翻(Correct→Incorrect):38%错误因模型过度验证推翻正确答案;

死循环(Wrong→Wrong):陷入错误推理链无法跳出。

模型对复杂问题减少实际计算,依赖直觉猜测:

矩阵秩问题中,计算步骤占比从65%(Lv1)→40%(Lv7);

当执行计算时,正确率反而更高(算术非唯一瓶颈)。

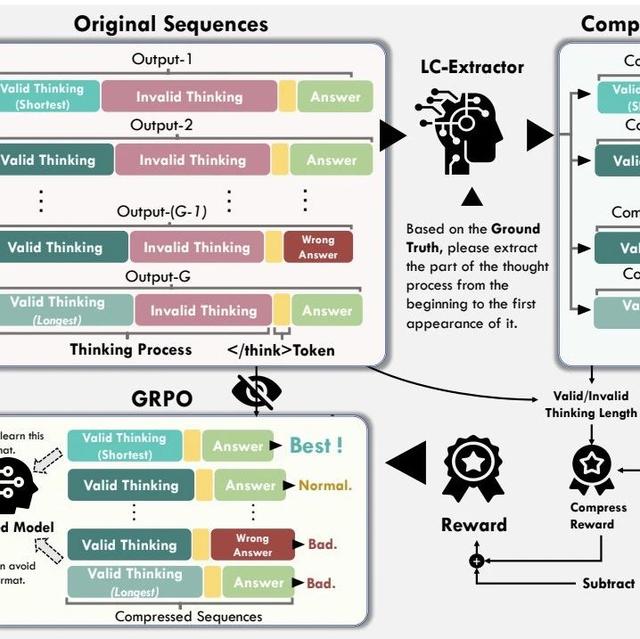

基于Qwen2. 5的RL实验显示:

探索性泛化:ID任务提升61%(如ZebraLogic),但OOD任务仅升8%;

组合性泛化:单一技能提升70%,但技能融合几乎无增益;

变革性泛化:OOD任务准确率接近0%,RL甚至强化错误策略。

模型能掌握独立技能(如几何旋转或模式匹配),但无法动态整合:

人类数学家:像乐高组合技能→LLM:像分离的积木块

关键瓶颈:RL过度拟合特定模式,缺乏灵活组合的元能力。

OMEGA揭示了LLM数学推理的深层瓶颈:机械重复易,创新组合难。其价值不仅在于暴露缺陷,更在于提供可操作的改进坐标系——

短期:需针对性数据增强(如变革性策略示例);

长期:需根本性架构创新(如符号-神经混合模型)。当模型学会\“舍弃旧策略\“时,才是迈向数学创造力的起点。

备注:昵称-学校/公司-方向/会议(eg. ACL),进入技术/投稿群

id:DLNLPer,记得备注呦