论文简读|OneIG-Bench 用于图像生成的全维度细致评估基准|含最新开源模型Show-o2、OmniGen2!

仅用于站内搜索,没有排版格式,具体信息请跳转上方微信公众号内链接

AIGCResearch

用于图像生成的全维度细致评估基准OneIG-Bench!!!目前,OneIG-Bench的测试prompts,生图脚本和评测脚本均已开源。

作者:JingjingChang,YixiaoFang,PengXing,ShuhanWu,WeiCheng,RuiWang,XianfangZeng,GangYu,Hai-BaoChen

机构:SJTU,StepFun

论文:https ://arxiv. org/abs/2506. 07977

代码:https ://github. com/OneIG-Bench/OneIG-Benchmark

主页:https ://oneig-bench. github.io/

文本生成图像(Text-to-image,T2I)模型因其能够根据文本提示生成高质量图像而受到广泛关注。现有的文生图评测基准的局限性主要如下:

缺乏部分垂类能力评估:文生图模型的快速发展也暴露了早期评估基准的局限性,缺乏对推理能力、文本渲染和风格表现等多方面的全面评估。

多数评测基准不支持灵活测评:已有的评测基准部分存在prompts数量多,研究者在评测前生图耗时且评测成本较高。

Prompts多样性缺乏:当前已有的评测基准的prompts多数在长度,形式,语言等维度上形式单一。

图1:OneIG-Bench数据集的数据统计信息。左侧:OneIG-Bench数据集中prompts的词数分布。右侧:OneIG-Bench数据集中任务类型分布。

OneIG-Bench数据集由六个prompts集合组成:前五类分别为245条动漫与风格化、244条人物肖像、206条通用物体、200条文本渲染以及225条知识与推理提示词,每类均提供英文和中文版本;第六类为200条多语言prompts。同时,这些prompts总体上满足长度维度短(030词):中(3060词):长(>60词)=1:2:1的基本要求,且包括自然语言型prompts和标签型/短语型prompts。

OneIG-Bench的作者设计了一个半自动化流程,用于构建prompts多样性,安全性更好的数据集。

语义对齐:参照DSG链路,利用GPT-4o生成问题图谱,并由Qwen2. 5-VL-7B回答问题,通过回答正确率评估图像与提示词在语义上的匹配程度。

文本渲染:通过编辑距离(ED)、文本完成成功率(CR)和词语(汉字)准确率(WAC)三个指标,评估生成图像中文字与prompts中目标文本的一致程度,并结合为一个综合文本分数。

推理能力:首先基于prompts生成对应的文本答案,使用LLM2CLIP计算该答案与生成图像之间的语义相似度,用于衡量模型推理能力。

风格化能力:使用两个风格编码器(CSD和OneIG风格化图像编码模型)提取风格特征,计算生成图像与参考图像之间的风格相似度,作为模型风格表达能力的评分依据。

生成多样性:基于DreamSim计算同一prompts下生成图像两两之间的余弦相似度,取均值经代数变换后用于衡量模型在同一语义条件下生成图像的多样性。

OneIG-Bench通过对22个开源和闭源文生图模型进行全面评测,揭示了目前文生图模型在不同维度存在的问题。

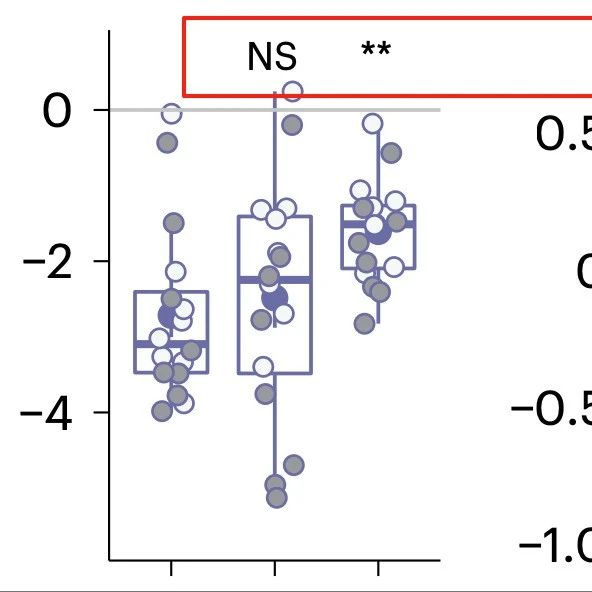

图2:22个文生图模型在OneIG-Bench上的总体表现。其具体的参数配置和时间戳可参考论文。AssessmentSets对应的是每个评测维度对应的prompts生成图的集合。

总体来看,闭源模型的结果整体要优于现有的开源模型。在所评测的维度里,多数模型在语义对齐维度都具有较高的水准。但在文字渲染任务上,模型间的能力差距较大。Seedream3. 0和GPT-4o在英文和中文的文字生成上都展示出了不俗的实力。推理方面,模型得分普遍不高,这也从侧面说明出文生图模型的推理能力仍然是一个值得研究的领域,需要在未来重点解决。风格化能力方面,从结果上看部分模型已经具备了初步了响应prompts中风格要求的能力。

图3:10个文生图模型在OneIG-Bench-ZH上的总体表现。其具体的参数配置和时间戳可参考论文

论文中包括了语义对齐与多样性,文本渲染,推理能力和风格化等评测维度的细粒度分析。这里选取文本渲染能力的细粒度分析作展示并提供一些观点。

Seedream3. 0在几乎所有细分指标(完成率、词准确率)以及短/中长度提示词下的编辑距离方面均表现最佳。

GPT-4o尽管生成的图像视觉质量较强,但在量化指标上并无优势。这主要因为评估标准严格,大小写错误也计入编辑距离,从而拉低了GPT-4o的得分。

RecraftV3在所有长度类别中均表现出极佳的编辑距离,但RecraftV3在完成率和词准确率上的表现相对一般,这可能与其“先生成布局再填充文本”的策略有关。

这篇论文提出了一个全面的文本生成图像评估基准——OneIG-Bench,设计了多个通用场景,包括人物肖像、常规物体、文本渲染场景以及动漫/风格化场景,并为每类场景制定了相应的评估指标,以全面衡量文本生成图像模型的表现。通过将评估划分为不同的维度,该基准有助于深入比较不同模型在各个方面的优势与不足。这一方法不仅为研究人员提供了严谨的评估框架,也为发现技术瓶颈、明确方法创新优先级提供了指导工具。

知识与推理是图像生成领域中相对新颖的任务,目前大多数模型尚缺乏稳健的推理能力。尽管评分结果与人工评估具有较高一致性,但仍可能存在更合理、更有效的评估方法尚待探索。

目前的审美模型往往存在一定的偏差,而人体质量评估模型则普遍缺乏足够的判别能力和泛化性。这两个方面的进一步研究将有助于构建更稳健、更精准的评估方法。