ICCV 2025 | 湖南大学提出全新无源遮挡感知分割框架 UNLOCK,全景理解性能碾压传统 UDA 方法

仅用于站内搜索,没有排版格式,具体信息请跳转上方微信公众号内链接

点击上方“小白学视觉”,选择加\“星标\“或“置顶”

重磅干货,第一时间送达

在计算机视觉的浩瀚领域中,场景理解始终是一项核心任务,它如同智慧的眼睛,为自动驾驶、虚拟现实和机器人技术等众多下游应用提供关键支撑。然而,当前的场景理解方法在实现全面且类似人类的环境感知方面遭遇重重挑战,犹如迷雾中的行者,难以看清前行的道路。今天,我们将深入探讨一篇发表于ICCV2025的论文《UnlockingConstraints:Source-FreeOcclusion-AwareSeamlessSegmentation》,看看它是如何披荆斩棘,为场景理解带来新的曙光。

全景图像处理对于全方位上下文感知至关重要,但面临着诸如畸变、透视遮挡和有限标注等限制。以往的无监督域适应方法将知识从有标注的针孔数据转移到无标注的全景图像,但它们需要访问源针孔数据。为了解决这些问题,作者引入了一个更实际的任务,即无源遮挡感知无缝分割(SFOASS),并提出了其首个解决方案,称为无约束学习全方位上下文知识(UNLOCK)。具体而言,UNLOCK包括两个关键模块:全方位伪标签学习和非模态驱动上下文学习。该框架在不依赖源数据或目标标签的情况下进行适应,同时增强模型以实现具有360°视角覆盖和遮挡感知推理的分割。此外,作者通过实到实和合成到实的适应设置对所提出的SFOASS任务进行了基准测试。实验结果表明,作者提出的无源方法实现了与有源依赖方法相当的性能,在mAAP中达到了10. 9的当前最优分数,在mAP中达到了11. 6的分数,与仅使用源数据的方法相比,mAPQ绝对提高了+4. 3。

场景理解在计算机视觉中占据着举足轻重的地位,它对于自动驾驶、虚拟现实和机器人技术等领域的发展至关重要。然而,现有的方法在多个关键方面存在不足,限制了其对场景的全面理解能力。

传统的场景理解方法大多是为针孔图像量身定制的,其视野范围(FoV)狭窄,就像透过一根管子看世界,只能看到有限的部分。而全景视觉虽然能够一次性提供360°视角,有望促进更全面的场景理解,但由于畸变等问题,直接将传统方法应用于全景数据往往效果不佳。因此,如何有效地将知识从针孔域转移到全景域,学习全方位上下文知识,成为实现无缝360°场景理解的关键。

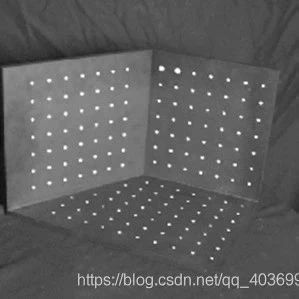

非模态感知,即预测被遮挡物体完整形状的能力,是稳健场景理解的关键要素,体现了类似人类的感知水平。扩展视野深度意味着模型要实现无缝感知,包括背景的像素级分割和前景的遮挡感知实例级分割。然而,目前的非模态分割方法在同时改进深度和视野方向的遮挡感知推理方面仍面临巨大挑战。

在全景视觉中,标记数据的稀缺性是一个严重的限制因素。为了解决这个问题,无监督域适应(UDA)方法应运而生,它利用源域的标记数据和目标域的未标记数据进行训练。然而,UDA方法仍然依赖于对源域的访问,这在实际应用中可能会受到隐私问题或商业限制的影响,例如在自动驾驶领域。因此,如何在没有源数据的情况下使模型适应全景域,成为一个亟待解决的问题。

为了解决上述挑战,论文作者提出了一个全新的任务——无源遮挡感知无缝分割(SFOASS),并给出了首个解决方案——无约束学习全场景上下文知识框架(UNLOCK)。

SFOASS任务旨在让模型在无需源数据和目标标签的情况下,实现360°视角覆盖的分割和遮挡感知推理。这一任务的提出,为解决全景视觉中的实际问题提供了新的思路。

UNLOCK框架包含两个关键模块:全方位伪标签学习(OPLL)和非模态驱动上下文学习(ADCL)。这两个模块协同工作,使模型能够在无源约束下适应目标全景域,实现无缝感知。

在SFOASS任务中,只能访问无标注的目标全景图像。常见的伪标签生成方法在SFOASS中会导致实例和非模态实例分支的性能下降。为了解决这个问题,作者开发了OPLL方法。

OPLL方法引入了类自适应自调整(CS)阈值生成全方位伪标签,并应用不确定性引导的实例损失。具体来说,首先利用语义分支的预测对两个实例级分支的预测施加额外的约束,修正实例级预测的对象掩码。然后,通过CS阈值方法确定高质量的预测作为确定的伪标签,并将其他预测的剩余掩码视为不确定性区域,形成全方位伪标签。最后,在目标模型的适应过程中,语义分支使用交叉熵损失,实例级分支引入不确定性引导二元交叉熵(BCE)损失。

OPLL主要从源模型中提取域不变知识,而ADCL策略则在整合域不变知识的同时学习域内知识。传统的混合策略不适用于具有非模态实例分支的OASS模型,会混淆语义上下文并阻碍模型学习。

为了解决这个问题,作者通过应用更严格阈值的OPLL创建一个包含高质量对象样本的缓冲池,形成非模态驱动的对象池。然后,基于这个对象池引入空间感知混合策略,生成非模态驱动的混合样本,在尊重全景布局的同时丰富无标注全景图像的多样性。这种策略保留了对象的完整形状,避免了对其他对象语义内容的混淆,提高了模型从目标全景域学习上下文知识的能力。

在K2B基准上,UNLOCK在场景理解的关键指标mAPQ、mPQ和mIoU上分别比基线仅源模型提高了+4. 3、+2. 8和+2. 9,在实例级分割中超越了所有现有的UDA方法。在A2B基准上,UNLOCK在所有SFOASS指标上都显著超越了360SFUDA++。

通过在K2B场景上进行的消融研究,验证了OPLL和ADCL的有效性。OPLL能使源模型的知识有效适应目标域,ADCL解决了对象混合策略中的问题,结合两者的UNLOCK方法实现了最佳的整体性能。此外,骨干网络消融实验表明UNLOCK在各种骨干架构上保持一致的性能。

这篇论文通过引入SFOASS任务和UNLOCK框架,为解决全面场景理解中的关键约束提供了有效的解决方案。实验结果充分证明了该方法的有效性和优越性。未来,随着计算机视觉技术的不断发展,相信这种无源遮挡感知无缝分割的方法将在更多领域得到应用,为我们的生活带来更多的便利和创新。

总之,这篇论文为计算机视觉领域的发展做出了重要贡献,为我们打开了一扇通往更全面、更智能场景理解的大门。让我们期待它在未来的研究和应用中绽放出更加耀眼的光芒。

下载1:OpenCV-Contrib扩展模块中文版教程

在「小白学视觉」公众号后台回复:扩展模块中文教程,即可下载全网第一份OpenCV扩展模块教程中文版,涵盖扩展模块安装、SFM算法、立体视觉、目标跟踪、生物视觉、超分辨率处理等二十多章内容。

下载2:Python视觉实战项目52讲

在「小白学视觉」公众号后台回复:Python视觉实战项目,即可下载包括图像分割、口罩检测、车道线检测、车辆计数、添加眼线、车牌识别、字符识别、情绪检测、文本内容提取、面部识别等31个视觉实战项目,助力快速学校计算机视觉。

下载3:OpenCV实战项目20讲

在「小白学视觉」公众号后台回复:OpenCV实战项目20讲,即可下载含有20个基于OpenCV实现20个实战项目,实现OpenCV学习进阶。

交流群

欢迎加入公众号读者群一起和同行交流,目前有SLAM、三维视觉、传感器、自动驾驶、计算摄影、检测、分割、识别、医学影像、GAN、算法竞赛等微信群(以后会逐渐细分),请扫描下面微信号加群,备注:”昵称+学校/公司+研究方向“,例如:”张三+上海交大+视觉SLAM“。请按照格式备注,否则不予通过。添加成功后会根据研究方向邀请进入相关微信群。请勿在群内发送广告,否则会请出群,谢谢理解~