仅用于站内搜索,没有排版格式,具体信息请跳转上方微信公众号内链接

论文地址:https ://arxiv. org/pdf/2201. 00520

该模块通过数据依赖的方式选择自注意力中的关键和值对的位置,使模型能够灵活地关注相关区域并捕捉更有信息量的特征。这种设计不仅提高了模型对长距离依赖关系的建模能力,还避免了传统密集注意力机制(如ViT)带来的高计算成本和过拟合风险,同时也克服了稀疏注意力机制(如PVT或SwinTransformer)数据不可知的局限性。

基于提出的可变形自注意力模块,构建了一个通用的金字塔结构骨干网络,适用于图像分类和密集预测任务。DAT模型在多个阶段采用了局部注意力和可变形注意力的交替设计,这种设计使得模型能够在局部和全局范围内灵活地捕捉特征。

文章通过消融研究验证了可变形自注意力模块中各个组件的有效性,包括可变形偏移量和可变形相对位置嵌入的作用。

本文的主要研究方法是提出了一种新型的可变形自注意力模块,并基于此构建了一个通用的金字塔结构骨干网络——DeformableAttentionTransformer(DAT),用于图像分类和密集预测任务。具体来说,研究者们首先回顾了Transformer在视觉任务中的应用,特别是VisionTransformer(ViT)和SwinTransformer等模型,指出了这些模型在处理视觉任务时存在的问题,如计算成本高、过拟合风险以及对长距离依赖关系建模的局限性。为了解决这些问题,他们提出了一种数据依赖的可变形自注意力机制,该机制通过学习查询特征来生成偏移量,从而将关键和值对的位置从均匀网格移动到更重要的区域。这种设计不仅保持了线性空间复杂度,还引入了可变形的注意力模式,使得模型能够更灵活地关注相关区域并捕捉更有信息量的特征。

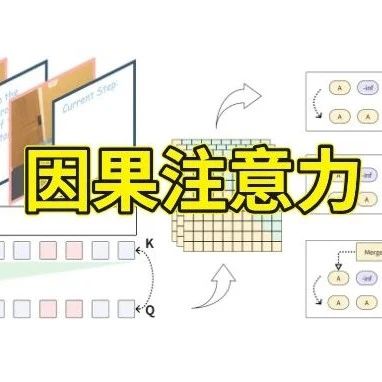

本图展示了DAT与其他VisionTransformer模型(如ViT和SwinTransformer)以及CNN模型(如DCN)的比较。图中用红色和蓝色星星表示不同的查询,用实线边界表示查询关注的区域。ViT采用全注意力机制,SwinTransformer采用分区窗口注意力,而DAT则通过数据依赖的方式学习共享的偏移量,将关键和值对的位置移动到更重要的区域。这种设计使得DAT能够更灵活地关注相关区域,捕捉更有信息量的特征。

本图详细展示了可变形注意力机制的信息流。左侧部分展示了如何从输入特征图中生成参考点,并通过偏移网络生成对应的偏移量。然后,根据偏移后的点对特征图进行采样,得到偏移后的关键和值对。右侧部分展示了如何通过多头注意力机制对查询和偏移后的关键和值对进行处理,最终输出变换后的特征。图中还展示了如何通过偏移点的位置计算相对位置偏置,增强多头注意力机制。

本图展示了DAT的网络架构。输入图像首先通过一个4×4的非重叠卷积进行嵌入,得到初始的patchembeddings。然后,网络分为四个阶段,每个阶段的特征图逐步下采样,特征维度逐步增加。在第三和第四阶段,网络交替使用局部注意力和可变形注意力模块,以实现对局部和全局特征的有效捕捉。这种交替设计有助于模型学习更强的特征表示。

本表提供了在ImageNet-1K数据集上进行图像分类任务时,DeformableAttentionTransformer(DAT)模型与其他VisionTransformer模型的性能比较。表中详细列出了不同模型的计算复杂度(FLOPs)、参数数量(#Param)以及Top-1准确率(Top-1Acc.)。这些数据表明,DAT模型在保持较低计算复杂度的同时,实现了更高的分类准确率,证明了其在图像分类任务中的优越性能。具体来说,表中列出了包括DeiT、PVT、GLiT、DPT、SwinTransformer和DAT在内的多种VisionTransformer模型。每个模型都有不同的架构和性能特点,这些特点在表中通过其计算复杂度、参数数量和Top-1准确率来体现。这些结果表明,DAT模型通过其独特的可变形注意力机制,在图像分类任务上不仅提高了性能,而且在计算效率上也具有优势,使其成为一种有潜力的视觉任务解决方案。

–END–

最后对注意力机制创新感兴趣的可公众号后台私信‘加群’或者扫描下方👇二维码进入注意力机制交流群!

关注“学姐带你玩AI”公众号,回复“注意力全新”

领取注意力机制高分论文合集+开源代码

往期推荐:

只做注意力机制怕是不够了,想要高分得加快速傅里叶变换!

姚期智团队开源新型注意力机制!降本90%…2025发顶会还得靠Attention

Kimi“撞车”DeepSeek!新一代注意力机制的极限突破!

注意力机制又见神操作!结合多尺度特征提取涨点起飞!看似简单,实则也不难

注意力机制还是太全面!结合可变形卷积直接拿下顶会!高分套路可放心尝试

ACCEPT

据说点赞的都Accept了!