仅用于站内搜索,没有排版格式,具体信息请跳转上方微信公众号内链接

Qwen3-0. 6B是阿里巴巴通义千问团队于2025年4月发布的开源大型语言模型系列中的最小版本,拥有6亿参数。在大型语言模型(LLM)日益庞大、动辄数十亿参数的今天,Qwen3-0. 6B这样仅有6亿参数的小模型是否还有存在的意义?它是否只是技术展示的「玩具」,还是在实际应用中有其独特的价值?一起来答主们的回答吧~

它主要不是拿来做复杂对话或者生成文本的,而是跑一些比较轻量的任务,比如query改写、语义增强、用户意图识别、浅层打分,或者生成embedding做召回匹配。

如果你接触过真正的线上服务,尤其是搜索、推荐这类每天跑千万级请求的系统,你会发现,这种小模型才是真正能干活的。

很多业务链路对延迟的要求非常严格,精确到个位数毫秒,QPS又是成千上万,根本没办法把大模型塞进去。你要真上个7B,别说延迟崩了,GPU和预算都一起爆。这个时候,像Qwen-0. 6B这种小模型就有优势了,资源吃得少,还能支持高并发。

它主要不是拿来做复杂对话或者生成文本的,而是跑一些比较轻量的任务,比如query改写、语义增强、用户意图识别、浅层打分,或者生成embedding做召回匹配。这些任务不需要模型懂很多道理,只要能对输入有点感知,提点信号出来,就够用了。

更关键的是,很多场景都不是一个输入跑一次模型那么简单,而是一个query对上成百上千个候选item,也就是query×item的维度,一个请求就要做几千次推理。如果模型不够小,延迟根本压不下来,根本上不了主链路。

这些活过去是BERT的地盘,比如TinyBERT、DistilBERT,但现在越来越多像Qwen这样的轻量LLM架构模型开始接管这类任务。Qwen这类模型继承了大模型的架构优势,比如RotaryPositionEmbedding、解码器风格的设计、KVCache支持等等。训练数据规模也比原来的BERT强不少,所以泛化能力和适应性都更好。

这类模型的核心目标也不一样:不是拼最终准确率,而是只要能「加一点点额外信号」就好。

因为排序任务本来就没有标准答案,只要整体排序比原来好一些,效果就提升了。模型不需要非常准,只要有一点点启发性信号就足够。

说白了,0. 6B不是拿来当主模型的,它是辅助模块,是系统里加特征、加signal的一环。它要的不是模型多强,而是模型够快、够轻、够稳。它只要在系统里跑得稳、用得起、效果能提一点点,就已经非常有价值了。

讲一个大家可能没想到的用法吧:这种小模型,是可以用来充当内容合规安全和的第一道防线的。

|答主:桔了个仔

讲一个大家可能没想到的用法吧:这种小模型,是可以用来充当内容合规安全和的第一道防线的。

我给一些伙伴做过一些LLM系统部署方面的指导。其实一个生产环境下的LLM系统,并非像大家想的一样,接个API或者部署个deepseek就完事了。在生产环境中,必须重视合规和安全。

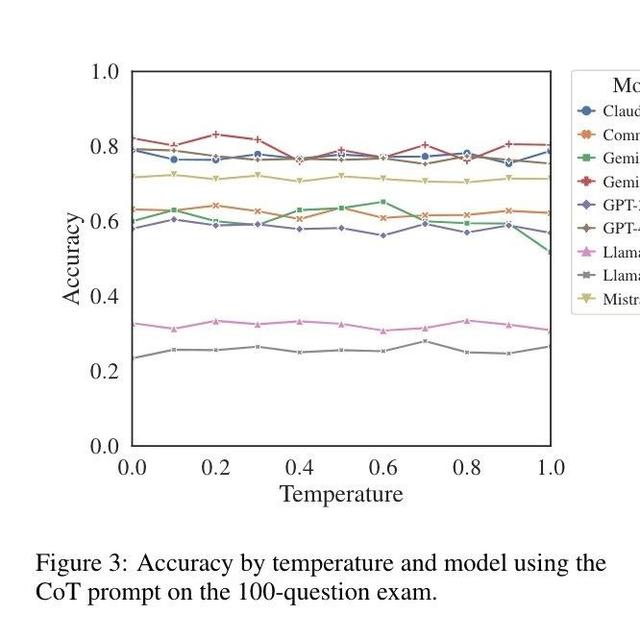

下面是一张生产环境中如何使用LLM构建问答系统的图,我们需要对用户输入和模型输出都做合规检查。

当然,这个世界上并没有100%安全的环境,大公司也一样会偶发事故,但是内容安全这个事,随着你投入的成本增加,其边际收益会递减。大概如下图的趋势。

多数情况下,我们需要在成本和准确率之间取得平衡。

当然,内容安全全部交给大模型来做,准确率应该更高,但对于高并发的系统而言,这是一个成本很高的方案。因此,为了降低成本,同时提升准确率,我们需要第一道防线。

而小模型(尤其是微调过的小模型),很适合这道防线。如果说大模型对于有害内容识别的能力是99分,小模型的识别能力可能是60分,而微调过的小模型,可以达到80分,这意味着,以几百分之一甚至千分之一的成本,能取得80%的效果。

这也是为啥你用一些在线大模型服务时,你一输入不合规内容,它就能一秒钟返回提示让你修改,而内容合规时,它回复却很慢的原因,因为有害输入,很多时候,都是小模型检测出来的。

对移动端意义非凡。每秒55-60tokens,有苹果的芯片和特殊优化加持只会更高。这个速度和模型回答质量,相比于Qwen2. 5-0. 6B进步巨大,完全可以满足笔记总结、MCP工具简单调用等场景。

|答主:狄拉克之海

对移动端意义非凡。

不妨想一想Qwen为什么宁愿舍弃世界知识储备也要做119种语言支持,是哪个厂商的产品会有以下要求?

强隐私需求,要端侧推理

业务范围超广,需求近乎支持全球90%以上的语言

模型足够小,移动端也能运行推理并且取得相对不错的质量和速度

比较强的MCP工具调用能力

答案可以从阿里巴巴最近最大客户名单中找到——苹果。

只有苹果才有如此迫切的需求,而Qwen3-0. 6B以及一系列小模型针对以上需求取得了不错的成绩。显然,Qwen许多的性能指标是为了满足苹果AI功能的要求,千问团队是苹果大洋彼岸异国异司的LLM开发部。

那么有人就要问了,移动端端侧推理效果究竟如何?

这是Qwen3-0. 6B在我的骁龙8至尊版运行效果。

每秒55-60tokens,有苹果的芯片和特殊优化加持只会更高。这个速度和模型回答质量,相比于Qwen2. 5-0. 6B进步巨大,比其他相同大小的模型只会答非所问更是不知道高到哪里去了,完全可以满足笔记总结、MCP工具简单调用等场景。

除此之外,Qwen3-0. 6B还有哪些优势呢?

答主@王林小儿认为可以将Qwen3-0. 6B当作一个性能非常好的基座模型,去训练专业领域的东西,并列举了一些实际应用的例子。

答主@密排六方橘子说「LLM时代也不要忘了传统玩法。LLM不仅仅是一个『开箱即用』的模型,也是一个pretrain的backbone,你完全可以在一些特定的下游任务上把它单纯当预训练权重用,拿去替代bert等模型。」