大模型架构变天!Mamba架构实现推理性能超Gemma3-27B!推理模型开始迈入「无注意力」时代

仅用于站内搜索,没有排版格式,具体信息请跳转上方微信公众号内链接

点击上方“小白学视觉”,选择加\“星标\“或“置顶”

重磅干货,第一时间送达

MLNLP社区是国内外知名的机器学习与自然语言处理社区,受众覆盖国内外NLP硕博生、高校老师以及企业研究人员。

社区的愿景是促进国内外自然语言处理,机器学习学术界、产业界和广大爱好者之间的交流和进步,特别是初学者同学们的进步。

来源|AI科技评论

推理大模型中的注意力机制可以去掉吗?这是当下最具挑战性的开放问题之一。过去半年,伴随长思维链的爆火,模型在复杂推理任务中普遍需要生成成千上万的tokens才能产出高质量解答。然而,这也与Transformer架构天然矛盾:随着生成长度的增长,Attention模块需要不断堆积Key-ValueCache,带来线性增长的显存消耗与二次方增长的计算复杂度,直接限制了推理深度、解码速度与部署成本。

半年以来,学术界与产业界在持续探索“去注意力机制”的模型架构:腾讯混元提出HunyuanTurbo-S、Nvidia发布Nemotron-H、TriDao也在M1中尝试了极致的Mamba-Attention混合架构。这些混合模型虽然显著减少了Attention占比,但仍未能完全摆脱对注意力机制的依赖,Key-ValueCache依然存在,解码复杂度仍受限于推理链长度。

与此同时,DiffusionLLM(dLLM)路线也在最近快速升温,试图跳脱传统自回归范式,通过MaskedDenoising等迭代去噪机制优化解码过程。然而,本质上大多数dLLM仍构建在Transformer架构之上,核心依赖注意力机制完成每轮去噪迭代。在解码阶段,dLLM需要多轮完整的序列更新,每轮都需重新激活Attention计算,导致计算复杂度依然呈二次增长、Key-ValueCache持续膨胀,长推理链生成的内存开销和解码时延甚至较自回归模型更高。换言之,现有dLLM尚未摆脱注意力机制的束缚。

那么,究竟有没有可能完全移除注意力机制,同时在复杂推理任务上做到高效与强大兼备?最近,蚂蚁技术研究院联合香港大学发布了PromptCoT-Mamba-7B,首次实现了解码显存常量、计算复杂度线性、长上下文稳定扩展的推理大模型。至此,推理大模型终于可以完全不依赖注意力机制而运作起来了!

模型概览

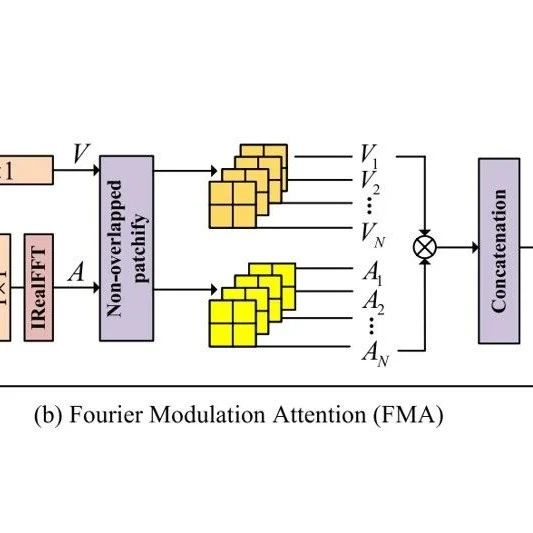

无注意力架构:全模型仅基于Mamba-2的SSD层,无需Key-ValueCache,彻底消除随生成长度增长的内存负担;

线性时间复杂度:得益于状态递推设计,每生成一个token的计算复杂度为O(NP),而非Transformer的O(TN),其中T为序列长度,N,P为隐藏维度。解码速度在长序列条件下具备绝对优势;

强大的推理能力:首次在竞赛数学与代码推理任务上全面超越同尺寸及更大规模的Transformer以及混合架构;

开放通用的训练框架:将PromptCoT扩展为跨领域数据合成范式,不仅支持奥数题,更系统性地扩展到了复杂代码生成任务,支撑起完整通用的推理模型训练框架。

技术报告地址:https ://arxiv. org/abs/2505. 22425

GitHub:https ://github. com/inclusionAI/PromptCoT

模型效果

1. 主实验:首个击败Transformer的无注意力推理大模型

在主实验设定下,PromptCoT-Mamba-7B在无需任何注意力机制与Key-ValueCache的前提下,首次在竞赛级数学与代码推理任务中全面超越同尺寸甚至更大尺寸的Transformer系列模型,验证了注意力之外的结构化建模潜力:

和Transformer强基线模型s1. 1-7B相比,AIME2024提升16%,AIME2025提升7. 1%,LiveCodeBench-v5提升16. 6%。

在AIME2024,AIME2025,以及LiveCodeBench-v5上甚至超过了Google的Gemma3-27B。

2. 数学专项提升:极限推理能力释放

在进一步领域特化设定下,数学专属版本PromptCoT-Mamba-Math-7B显著提升模型在数学复杂推理任务中的表现:

AIME24:提升至42. 9%(相比通用版提升+7. 7%)

AIME25:提升至30. 8%(相比通用版提升+6. 2%)

3. 常量内存推理效率:无注意力架构优势凸显

得益于完全去除注意力机制及Key-ValueCache,PromptCoT-Mamba-7B在长序列解码与低内存部署环境下展现出显著的效率优势:

在24GBGPU低资源设定下,相较Transformer,推理吞吐达到其3. 66倍

在72GBGPU设定下,相较Transformer,推理吞吐达到其1. 69倍

这使得PromptCoT-Mamba成为长上下文与实际工程部署的高效架构选择。

更多技术细节

1. PromptCoT问题合成框架

PromptCoT[ 1]是研究团队于2025年3月推出的问题合成框架。其基本思想是从概念出发,通过生成Rationale来模拟人类专家在命题过程中的抽象思路与逻辑组织,最终Rationale类似于设计架构,和输入概念一起指导竞赛级数学问题的合成。

在理论上,PromptCoT定义了最优Rationale的生成目标,要求其同时最大化:

Rationale在给定概念条件下的生成概率;

完整问题在已给定Rationale与概念条件下的生成概率。

在实现上,首先通过大语言模型生成针对现有竞赛级题目的Rationale样本,随后利用这些概念-Rationale-问题三元组训练问题生成模型,使其具备从任意概念集合自动构建高难度推理问题的能力。该机制不仅提升了样本生成的逻辑性与难度控制能力,也大幅缓解了复杂推理训练过程中的数据瓶颈问题。

在此基础上,经过版本迭代,PromptCoT实现了无注意力模型架构上数学和代码推理能力的同时突破。

2. 两阶段训练流程

PromptCoT-Mamba训练分两阶段:

初始阶段:以多领域覆盖式的高质量推理轨迹数据进行基础训练,约188万样本,涵盖数学、代码、逻辑、复杂文字推理任务,帮助模型快速掌握通用推理范式。

进阶阶段:引入PromptCoT合成的25万高难度问题样本,进一步雕琢复杂长链路推理能力。

推理阶段使用最大长度达64Ktokens的长序列推理,配合SSD架构特性,稳定高效。

结语展望:为无注意力推理大模型生态奠定技术基础

PromptCoT-Mamba不仅证明了无注意力架构在复杂推理任务上具备工业级应用潜力,更为未来Mamba体系的推理技术研究提供了完整可复用的技术栈与数据生成范式:

架构端:无注意力推理的可行性范式;

数据端:PromptCoT跨领域高难任务生成框架的普适扩展。

未来,任何复杂推理任务只需通过PromptCoT机制扩充领域概念库,即可快速构建新型纯MambaReasoning模型,成为无注意力推理大模型的新一代基座方案。

作者介绍

该工作第一贡献者为香港大学计算机系博士生赵学亮,师从孔令鹏教授;蚂蚁技术研究院武威为共同贡献者。

下载1:OpenCV-Contrib扩展模块中文版教程

在「小白学视觉」公众号后台回复:扩展模块中文教程,即可下载全网第一份OpenCV扩展模块教程中文版,涵盖扩展模块安装、SFM算法、立体视觉、目标跟踪、生物视觉、超分辨率处理等二十多章内容。

下载2:Python视觉实战项目52讲

在「小白学视觉」公众号后台回复:Python视觉实战项目,即可下载包括图像分割、口罩检测、车道线检测、车辆计数、添加眼线、车牌识别、字符识别、情绪检测、文本内容提取、面部识别等31个视觉实战项目,助力快速学校计算机视觉。

下载3:OpenCV实战项目20讲

在「小白学视觉」公众号后台回复:OpenCV实战项目20讲,即可下载含有20个基于OpenCV实现20个实战项目,实现OpenCV学习进阶。

交流群

欢迎加入公众号读者群一起和同行交流,目前有SLAM、三维视觉、传感器、自动驾驶、计算摄影、检测、分割、识别、医学影像、GAN、算法竞赛等微信群(以后会逐渐细分),请扫描下面微信号加群,备注:”昵称+学校/公司+研究方向“,例如:”张三+上海交大+视觉SLAM“。请按照格式备注,否则不予通过。添加成功后会根据研究方向邀请进入相关微信群。请勿在群内发送广告,否则会请出群,谢谢理解~