仅用于站内搜索,没有排版格式,具体信息请跳转上方微信公众号内链接

大型语言模型(如DeepSeek-R1)通过思维链(CoT)生成复杂推理路径,但传统强化学习方法(如GRPO)存在严重缺陷:过度追求答案正确性导致模型\“想太多\“(过思考)——生成冗长的推理步骤,降低效率且增加错误。为压缩长度,现有方法引入长度惩罚机制,却引发更致命问题:训练早期模型精度突然崩溃。

论文:StableReinforcementlearningforefficientreasoning

链接:https ://arxiv. org/pdf/2505. 18086

本文提出GRPO-λ,如同给模型配备\“智能教练\“:当模型推理能力弱时专注提升正确率;能力达标时再训练\“简洁表达\“。这种动态奖励切换机制,在五大数学/科学推理基准测试中实现47. 3%长度压缩+1. 48%精度提升,同时延长2. 5倍有效训练时长。以下逐层解析这一突破性工作。

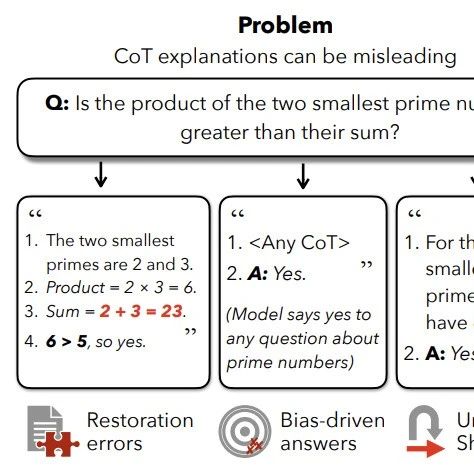

过思考的根源

GRPO等传统方法采用\“0/1奖励\“:仅根据最终答案对错给予奖励,忽略推理过程质量。

模型发现:生成更长思维链→包含正确步骤的概率↑→奖励期望↑→陷入无效步骤堆砌(如反复验算、无关推论)。

长度惩罚的陷阱

改进方案(如Kimi-1. 5)对长答案施加惩罚,强制模型缩短输出。

灾难性后果:如图1所示,训练早期长度快速下降时,精度突然崩塌。原因在于:

能力未达标时压缩长度:模型尚未掌握可靠推理能力,强行缩短步骤等同于\“让小学生写论文摘要\“,丢失关键逻辑链条。

奖励信号冲突:长度惩罚削弱正确样本奖励,模型陷入\“缩短文本\“与\“保持正确\“的对抗目标。

关键洞见:模型需经历能力发展阶段——先夯实基础精度,再优化效率。现有方法忽视这一规律,盲目统一压缩所有样本,终致崩溃。

\“幼儿先学走路,再学跑步\“

低能力组:专注正确率(标准0/1奖励)

高能力组:优化效率(长度惩罚奖励)

组采样

对每个问题生成多答案(如16个),记录长度和正确性(0/1)。

分组筛选(Top-λ筛选器)

计算每组答案正确率(如某问题16个答案中8个正确→正确率50%)。

按正确率排序,选出前λ%组(λ=20%):正确率高→已具备优化效率的基础。

动态奖励分配

效率优先组(Top-λ%):施加长度惩罚奖励(公式1),鼓励简洁:

正确错误

:Sigmoid函数,将长度偏差压缩到(0,1)区间

:本组所有正确答案的平均长度

:对应标准差

:惩罚强度(实验设0. 2)

符号解读:

核心作用:答案越短于组内平均水平,奖励越高;但不会无限制压缩(通过组内标准差自适应调节)。

精度优先组(剩余组):采用标准0/1奖励(公式2),专注提升正确率:

正确错误

每组内奖励标准化:

作用:消除组间差异,确保奖励信号可比性(如某组整体表现差时,其正确样本仍获相对高奖励)。

数据集:数学(GSM8K,MATH-500,AMC2023,AIME2024)+科学(GPQA)

对比方法:

Vanilla:基础模型

GRPO:传统强化学习

LP:长度惩罚(未崩溃时)

LP*:同等步数下崩溃的长度惩罚

GRPO-λ在压缩率52. 7%时,精度提升1. 48%(显著优于LP的55. 28%压缩率+0. 04%精度)

核心结论:

避免崩溃:LP*因强制压缩导致精度暴跌13. 42%,GRPO-λ无此问题。

效率-精度双赢:

在高难度数学任务(AIME/AMC)提升最显著:AIME精度↑1. 7%+长度压缩43. 1%

简单任务(GSM8K)保持精度同时压缩53%长度

训练稳定性:GRPO-λ可稳定训练100步以上,LP在40步后崩溃(见图1)。

Qwen3原始输出:6步推理,因冗余步骤导致最终错误。

LP输出:压缩至3步,但丢失关键推导而错误。

GRPO-λ输出:4步简洁推理,结果正确。

下图显示:当长度压缩至约5000token时,传统方法精度骤降。

GRPO-λ自动收敛于此阈值附近,实现帕累托最优:相同精度下长度更短,相同长度下精度更高。

λ=20%表明:仅对头部20%高能力组优化效率足以平衡全局。

过大λ(如50%)会导致过多组过早压缩,削弱基础能力。

训练策略

缺陷

GRPO

统一鼓励长答案

过思考

GRPO+LP

统一压缩长度

训练崩溃

本文揭示了强化学习训练中长度惩罚引发崩溃的根本矛盾,并提出动态能力分级策略GRPO-λ。其核心价值在于:

训练稳定性:通过正确率监控实现精度/效率目标自适应切换,避免早期崩溃。

帕累托突破:在五大基准实现47. 3%长度压缩+1. 48%精度提升的均衡优化。

方法论普适性:为LLM的\“能力阶段性训练\“提供新范式,可扩展至多目标优化。

未来工作将围绕自适应λ调控和崩溃边界预测深化,推动高效推理模型落地。