ICIR2025 | CubeDiff:无需考虑失真,重新利用基于扩散的图像模型来生成360°全景图

仅用于站内搜索,没有排版格式,具体信息请跳转上方微信公众号内链接

在之前的文章中已经给大家介绍过许多关于3D生成的文章,感兴趣的同学可以点击公众号菜单栏查看3D生成专栏,创作不易,欢迎大家点点赞和在看~

CubeDiff是一种使用基于扩散的图像模型生成360°全景图的新型框架。通过利用立方体图表示和微调预训练的文本到图像模型,CubeDiff简化了全景图生成过程,提供了高质量、一致的全景图。

CubeDiff利用立方体图来表示360°全景图,并在一次传递中同时对所有面进行降噪。与其他作品相比,Cubediff无需考虑失真,因为它在常见的90°FOV透视图像上进行操作,因此可以直接利用底层扩散模型的互联网级图像先验。该方法以最小的架构修改实现了最先进的结果,实现了详细的文本控制和出色的视觉保真度。

论文:http ://arxiv. org/abs/2501. 17162v1

主页:https ://cubediff. github.io/

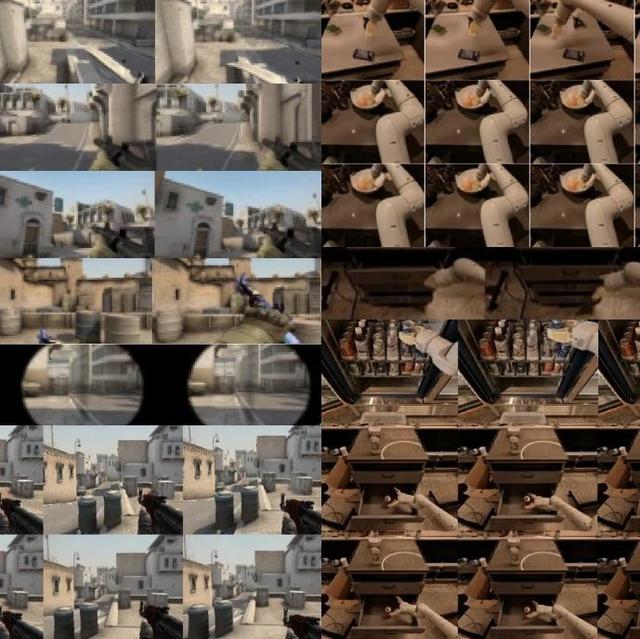

论文介绍了一种从文本提示或图像生成360°全景图的新方法。该方法利用3D生成方面的最新进展,采用多视图扩散模型来联合合成立方体贴图的六个面。与以前依赖于处理等距矩形投影或自回归生成的方法不同,提出的方法将每个面视为标准透视图像,简化了生成过程并支持使用现有的多视图扩散模型。论文证明这些模型可以适应生成高质量的立方体贴图,而无需对应感知注意层。该模型允许细粒度的文本控制,生成高分辨率全景图并远远超出其训练集,同时在质量和数量上都实现了最先进的结果。

CubeDiff引入了一种使用立方体贴图表示生成高质量360°全景图的方法,将全景图分为六个透视图,每个透视图的视野为90°。立方体贴图表示减轻了等矩形投影的典型扭曲,确保每个面都更接近原始训练数据中使用的透视图像。通过利用预训练的文本到图像扩散模型,CubeDiff使用膨胀的注意力层对潜在扩散模型(LDM)进行微调,实现跨视图一致性,同时保留预训练的注意力权重。

CubeDiff在128×128×8潜在空间上运行,根据文本嵌入和单个输入视图对LDM进行条件化,使用二进制掩码将干净的条件化潜在数据与嘈杂的目标潜在数据区分开来。同步组规范化确保各个面的颜色均匀,而从立方体贴图的3D几何中得出的位置编码则引导空间对齐。立方体贴图边缘的重叠预测通过确保相邻面之间的无缝过渡进一步增强了连贯性。使用标准扩散L2损失,在从等距矩形全景图派生的立方体贴图小数据集上仅微调LDM的注意层。

感谢你看到这里,也欢迎点击关注下方公众号并添加公众号小助手加入官方读者交流群,一个有趣有AI的AIGC公众号:关注AI、深度学习、计算机视觉、AIGC、StableDiffusion、Sora等相关技术,欢迎一起交流学习💗~