今日开源(2025-07-10):SmolLM3,3B小型语言模型突破,11.2T数据预训练,APO优化推理能力,支持六种语言

仅用于站内搜索,没有排版格式,具体信息请跳转上方微信公众号内链接

🏆基座模型

①项目:SmolLM3

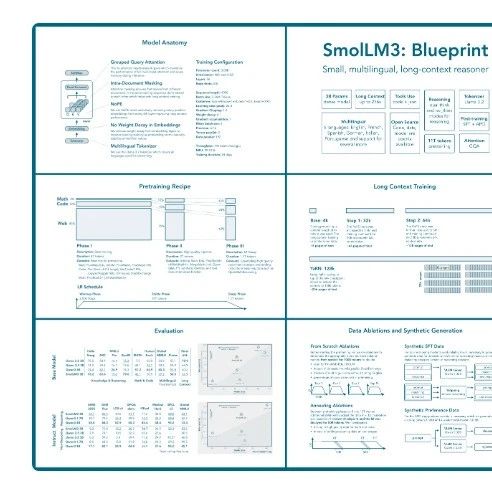

★SmolLM3是一个拥有30亿参数的语言模型,旨在推动小型模型的边界。该模型支持六种语言,具备高级推理能力和长上下文处理能力。SmolLM3是一个完全开放的模型,在3B-4B规模上提供了强大的性能。它是一个仅解码的Transformer模型,使用GQA和NoPE技术,预训练数据包括11. 2T的网络、代码、数学和推理数据,并通过分阶段课程进行训练。后期训练包括在140B推理数据上的中期训练,随后通过锚定偏好优化(APO)进行监督微调和对齐。

☆一键收藏:

https ://sota. jiqizhixin.com/project/smollm3

②项目:PhysiX

★PhysiX是首个大规模物理模拟基础模型,拥有4. 5B参数的自动回归生成模型。该项目旨在解决物理模拟领域的数据瓶颈问题,通过有效利用有限的数据资源,PhysiX在可比设置下超越了任务特定的基线模型,并在TheWell基准测试中表现优于之前的绝对最先进方法。

☆一键收藏:

https ://sota. jiqizhixin.com/project/physix

⚙️Robotics开发

①项目:UniVLA

★UniVLA是一个通用的视觉-语言-动作模型,旨在统一视觉、语言和动作的处理,特别适用于机器人和自动驾驶领域。该模型支持图像定位、视频生成和动作预测等任务,并在多个机器人基准测试中表现出色,如CALVIN、LIBERO和SimplerEnv。UniVLA通过交错的视频训练支持马尔可夫决策过程中的视觉-动作训练,应用范围广泛,包括真实机器人ALOHA和自动驾驶。

☆一键收藏:

https ://sota. jiqizhixin.com/project/univla

②项目:Fast-in-Slow

★Fast-in-Slow(FiS-VLA)是一种双系统基础模型,旨在将快速操作与慢速推理相结合。与以往的双系统视觉语言模型(VLA)方法不同,FiS-VLA将完整视觉语言模型(VLM)的最终Transformer模块重新用于系统1,同时保留完整模型用于系统2的推理。系统2处理低频2D图像和语言提示,将其转化为潜在特征以指导系统1,而系统1还处理高频输入,包括机器人状态、2D图像和点云,以实现稳健和响应迅速的动作生成。在这种范式下,FiS-VLA实现了卓越的性能和高频控制。

☆一键收藏:

https ://sota. jiqizhixin.com/project/fast-in-slow

🛠️框架平台、必备工具

①项目:MoCa

★MoCa项目旨在通过模态感知的持续预训练来提升双向多模态嵌入的效果。该项目支持文本、图像及其交错输入,能够在分布外数据上表现良好。MoCa在30B高质量交错数据上进行持续预训练,并通过对比微调在多样化的数据上进行优化。项目在MMEB和ViDoReV2基准测试中表现出色。

☆一键收藏:

https ://sota. jiqizhixin.com/project/moca

②项目:D-MoLE

★D-MoLE项目是ICML2025论文的官方实现,旨在通过动态混合课程LoRA专家实现持续的多模态指令调优。该项目提供了一整套训练和评估管道,支持多种数据集和预训练模型的使用。项目的目标是通过创新的架构搜索和训练方法,提升多模态任务的性能。

☆一键收藏:

https ://sota. jiqizhixin.com/project/d-mole