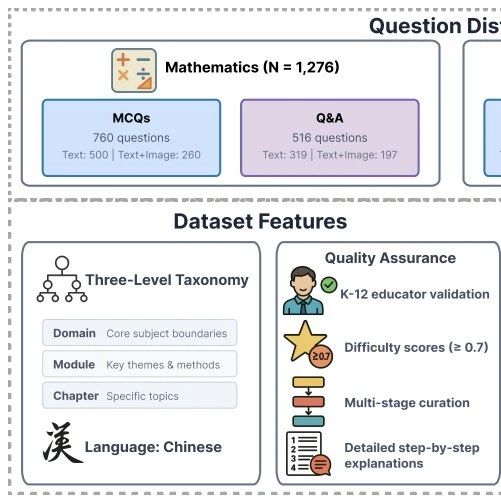

UIUC提出隐式监督新范式:无需标注/RM即可全面提升多模态Reasoning的感知能力

仅用于站内搜索,没有排版格式,具体信息请跳转上方微信公众号内链接

大型多模态模型(LMMs)在视觉问答、图像描述等任务中表现优异,但在复杂多模态推理(如几何证明、图表分析)中仍面临挑战。论文揭示:67%的错误源于视觉感知缺陷(如误读空间关系、标签关联),而非逻辑推理能力不足。这一瓶颈源于现有强化学习框架(如GRPO)的奖励设计——仅鼓励格式正确性和答案准确性,未强制模型利用视觉信息。

论文:Perception-AwarePolicyOptimizationforMultimodalReasoning

链接:https ://arxiv. org/pdf/2507. 06448

为此,作者提出PAPO(Perception-AwarePolicyOptimization),通过添加一个简单的KL散度项(隐式感知损失),驱动模型在推理过程中主动依赖视觉输入。其核心突破在于:

无需额外标注/奖励模型,仅通过内部监督信号提升感知能力;

在8个多模态基准上平均提升4. 4%,视觉依赖任务提升近8%;

首次在RL目标中实现感知与推理的深度协同优化。

多模态推理的独特挑战:文本大模型(LLMs)在数学证明等任务中表现出色,但LMMs需同时处理图像与文本。论文通过分析GRPO训练的模型(如Qwen-VL)发现:

67%错误由感知缺陷引起:例如将三角形边长x关联到错误位置。

奖励设计缺陷:现有RLVR奖励(格式奖励+答案正确性)不约束模型是否真正“看懂”图像。

现有改进方法的局限:

描述式奖励:要求模型先描述图像再推理,割裂感知与推理流程;

工具调用(如放大图像):未优化模型原生感知能力,依赖外部干预。

关键结论:多模态需重构优化目标,而非简单移植文本RL算法。

核心思想:若模型真正依赖视觉信息,则遮挡图像后其输出概率应显著降低。定义感知比率:

I:原始图像,Iₘₐₛₖ:随机遮挡60%区域的损坏图像

o:生成文本序列,q:问题比值越高→模型越依赖视觉信息。

为最大化该比值,引入KL散度目标:

物理意义:衡量模型在原始图像与损坏图像下输出分布的差异。差异越大,表明视觉信息贡献越显著。

优化方向:在GRPO目标中最大化该KL项(与最小化参考模型KL的方向相反),迫使模型关注视觉内容。

随机掩码:均匀遮挡图像块(简单高效,默认方案);

语义感知掩码:用DINOv2定位重要区域后遮挡(效果反而不佳,因过度移除整块语义,削弱局部关注)。

实验表明:遮挡60%-80%区域时效果最优(表3)。完全黑屏(100%)易引发KL黑客问题。

问题发现:当KLₚᵣₑₚ权重(γ)过高时,模型通过生成无关字符人为拉大KL值(称为\“KL黑客\“),导致奖励崩溃。

解决方案:监测到原始策略πθ与掩码策略πᵐᵃˢᵏ的熵值同步上升是崩溃前兆,因此添加熵正则项:

作用:约束模型生成低熵(高确定性)输出,避免通过随机字符“作弊”。

效果:完全抑制崩溃(图7),且性能优于单一熵正则(表5)。

在8个多模态基准(几何推理、数学问题、逻辑推断等)上:

PAPOvsGRPO:3B/7B模型平均提升4. 36%/4. 39%;

视觉依赖任务(如计数、空间推理):最高提升7. 96%(7B模型);

收敛速度:PAPO早期奖励增长更快。

错误类型分析显示:

GRPO:感知错误占比67%;

PAPO:感知错误减少近1/3,证明其有效解决核心瓶颈。

KLₚᵣₑₚ权重γ:

γ=0. 02时3B模型最优,但γ>0. 04引发崩溃;

大模型(7B)对γ更敏感,需更低γ值(0. 01)+双重熵正则。

掩码策略:随机掩码效果>语义掩码。

诱因:

大模型(7B)更易崩溃;

高γ值(如0. 04)或极端掩码(100%黑屏)加速崩溃。

崩溃征兆:

KLₚᵣₑₚ值骤降→奖励崩溃;

裁剪比率(clippingratio)持续上升→梯度更新异常;

πθ与πᵐᵃˢᵏ熵值同步升高。

双重熵损失有效性:通过压制熵增趋势,彻底阻断崩溃路径。

核心贡献:

提出首个将感知监督深度融入RL目标的框架PAPO,通过隐式感知损失(KLₚᵣₑₚ)解决多模态推理的视觉依赖瓶颈;

设计双重熵损失,有效抑制KL黑客问题,提升训练稳定性;

实现无需额外标注/奖励模型的高效优化,在8个基准平均提升4. 4%,视觉任务提升近8%。

研究价值:

挑战“仅通过数据/奖励改进多模态RL”的主流范式,证明优化目标重构的必要性;

为视觉接地推理(visuallygroundedreasoning)提供新方法论。

未来方向:

优化计算开销(PAPO单步训练时间增15%-30%);

扩展至InternVL等更大模型;

探索与动态采样、词级损失等技术的结合。