仅用于站内搜索,没有排版格式,具体信息请跳转上方微信公众号内链接

大家好,我是Ai学习的老章

经常在外冲浪,看到很多优秀的技术文章,独享不如分享

我会使用DeepSeek-R1+科技类翻译大师prompt翻译出来,大家一起学习

如有翻译偏差,请大家指教。原文[ 1]

演讲调皮的标题。

本自我介绍,提到他的基地在日本Musashino市,那里有吉卜力博物馆。他目前在Answer. AI从事机器学习研发。他开腔回到自己广为流传的个人照片,称其为“单图”,一张五年前的照片如今已经独立成章。他还提到了自己最近在ModernBERT上的工作以及与ColBERT相关的细节,承诺稍后会详细讨论。

本讨论了关于“RAG已死”的争议性观点。本解释说,这一说法仅适用于一种非常狭窄且经常被误解的RAG定义,这种定义是由营销活动普及开来的。

2023年很多人了解的“RAG”:这种简单的单向量语义搜索方法可能已经过时。然而,检索这一基本概念仍然relevant。

Ben拆解了这个缩写:RetrievalAugmentedGeneration。他指出,最初的RAG论文实际上描述的过程与今天常见的理解大不相同,但名称却保留了下来。其核心流程很简单:你以某种方式检索文档并将其传递给生成模型以增强其输出。他认为,总是需要向模型提供它们未经过训练的外部信息。

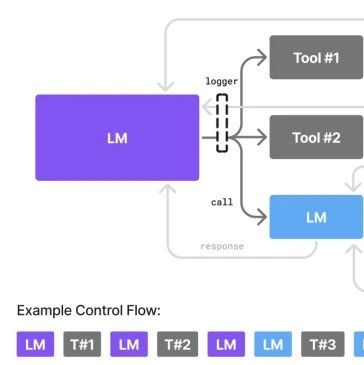

这张幻灯片展示了一个标准的简化LLM调用:输入一个提示,LLM生成响应,然后输出结果。这是理解RAG如何改变流程的基础。

使用RAG时,会插入一个新的步骤:“上下文文档”。本强调,获取这些文档的“方法”并不影响定义。如果你在上下文窗口中添加了外部文档以增强生成内容,你就是在进行RAG。即使手动复制粘贴文本到提示中,从技术上讲,这也是一种形式的RAG。

本指出,人们常用“RAG”来指代一种简单的暴力搜索,即基于单一向量的语义搜索。这种定义在2023-2024年由营销大力推动,因为它易于销售。他认为,因为现在使用了更好的检索工具就宣称RAG已经死亡,这就像说因为现在使用了CSS,HTML就已经死亡一样。

本解释了单向量搜索的局限性。它必须将整个文档或片段的意义压缩成一个相对较小的向量(例如,约1000维)。这种压缩不可避免地会导致信息丢失。模型是根据其训练数据(如必应搜索数据)训练的,优先处理它认为在将查询与文档匹配时有用的信息,而这些信息很可能与你的特定领域数据(例如,一个独特的代码库)不一致。正是这种不匹配使得通用嵌入模型在代码检索等专门领域中常常难以应对。

本解决了一个论点,即巨大的上下文窗口(例如,Gemini的1M或假设的10M令牌窗口)使RAG变得过时。他用了一个类比:就像1999年有人声称硬盘已经死亡,因为很快就会有512MB的RAM条。

实际情况是,即使是10M令牌对于许多企业的知识库或大型数据集来说也是一小部分空间。此外,将所有内容都塞进每次查询的上下文中的成本和低效率使其不切实际。

检索永远不会消失。LLM的权重在某个时间点被冻结。它们不知道你的新内部项目、更新后的公司政策,或者你想要尝试的“真的很酷的新fasthtml[ 2]库”。对每一条新信息进行训练是复杂且低效的。

Ben认为我们也不想让模型永久存储所有这些一次性信息;我们希望它们的有限权重空间用于智能,而不仅仅是知识存储。检索是注入这些外部、最新信息的必要手段。

本总结到目前为止的要点:

RAG并不会消失。

简单的方法(如基本的余弦相似度)已经显示出其局限性,推动我们向更好的、更复杂的检索技术发展。

RAG是向模型提供最新信息的最佳方式。

长的上下文窗口不能替代检索。文氏图说明了“死亡”的是那种用单一向量brute-force强制一切的简单想法,而不是RAG本身。

经典本-更多惊喜即将来临!

关于更好的检索方法,还有更多可以讨论的。

本又回到了他的类比。虽然更多的RAM没有杀死硬盘,但SSD确实做到了(对于消费者而言)。SSD只不过是一种“更好的硬盘”。同样地,“2023年的RAG”被杀死的原因仅仅是更好的RAG(具体来说,是更好的检索形式)。

为了展示检索的广度,Ben列出了各种工具:grep、wget、代理搜索、BM25、ColBERT、网络搜索,甚至推理。这些都是有效的检索方法。最好的方法通常是将它们结合起来使用。

Ben承认检索技术的复杂景观已经不再像过去那样简单。

制作不易,如果这篇文章觉得对你有用,可否点个关注。给我个三连击:点赞、转发和在看。若可以再给我加个,谢谢你看我的文章,我们下篇再见!

搭建完美的写作环境:工具篇(12章)图解机器学习-中文版(72张PNG)ChatGPT、大模型系列研究报告(50个PDF)108页PDF小册子:搭建机器学习开发环境及Python基础116页PDF小册子:机器学习中的概率论、统计学、线性代数史上最全!371张速查表,涵盖AI、ChatGPT、Python、R、深度学习、机器学习等

参考资料

原文:https ://hamel. dev/notes/llm/rag/p1-intro. html

fasthtml:https ://www. fastht.ml/